Энергоэффективность серверных помещений

Серверное оборудование — дорогостоящий элемент компьютерной системы, чаще всего работающий в режиме 365 дней в году, 24 часа в сутки. При этом серверы потребляют много электроэнергии. К тому же, надо обеспечить каждодневную бесперебойную работу серверов, и на это тоже нужна электроэнергия.

Проблема зашла так далеко, что в крупных городах России — Москве, Санкт-Петербурге — расширение деятельности крупных предприятий иногда ограничивается той электрической мощностью, которую энергоснабжающая организация может «выдать» на серверное хозяйство. Как сделать так, чтобы серверы в серверном помещении потребляли меньше электроэнергии — вот об этом и поговорим подробнее.

Термины и определения

Серверное помещение — это помещение, где размещается сложный инженерно-технический комплекс, состоящий из множества различных систем и устройств, работающих вместе и обеспечивающих хранение, обработку и передачу информации. Этот комплекс также включает инженерные системы и технические средства, необходимые для обеспечения правильной работы всего серверного и телекоммуникационного оборудования.

Компоненты серверного помещения:

- Сервера и системы хранения данных. Сюда относятся различные компьютеры, которые применяются для обработки и хранения информации и данных. Системы хранения данных представляют собой программно-аппаратные средства, используемые для хранения больших объемов информации.

- Телекоммуникационное оборудование. Обеспечивает подключение и передачу информации между устройствами — не только компьютерами, но и телефонными аппаратами, копировальной техникой и т.д., а также подключение к сети интернет через оператора связи.

- Инженерные системы:

- структурированная кабельная система, обеспечивающая связь телекоммуникационных и сетевых устройств ЦОД;

система кондиционирования, которая поддерживает определенный уровень температуры и влажности в компьютерном помещении;

- система пожаротушения, которая отвечает за пожарную безопасность;

- система электроснабжения, обеспечивающая компьютерное оборудование требуемой электрической мощностью с заданным качеством электропитания;

- система физической безопасности, в том числе система охраны, телевизионного видеонаблюдения, оповещения;

и другие системы.

- Система информационной безопасности. Сюда входит антивирусная защита, которая обеспечивает эффективную защиту от различных вирусов, спам–фильтр, который служит для фильтрации нежелательной информации, а также система защиты от вторжений, которая обеспечивает защиту от хакерских атак.

Проектирование и планирование ЦОД регламентируется американским стандартом ANSI TIA/EIA-942 (TIA-942) «Telecommunications Infrastructure Standard for Data Center».

Энергопотребление серверной комнаты

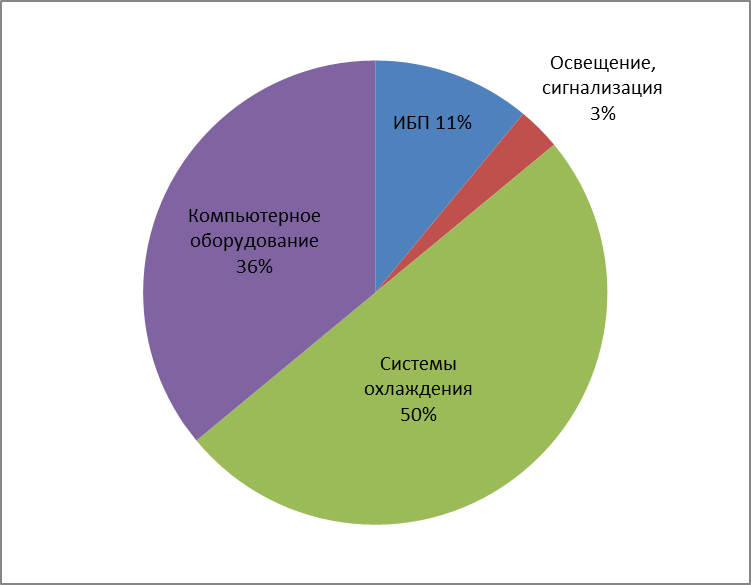

По данным аналитического департамента компании АРС, структура потребления электроэнергии современного дата-центра выглядит следующим образом: системы охлаждения (чиллеры, прецизионные кондиционеры, системы вентиляции) потребляют 50 %, собственно компьютерное оборудование — 36 %, источники бесперебойного питания (ИБП) — 11 %, освещение, пожарная сигнализация — 3 %.

Для оценки эффективности энергопотребления серверной комнаты применяется такой параметр как PUE (Power Usage Effectiveness) — показатель использования электроэнергии. PUE определяется как отношение суммарной потребляемой серверным помещением за год мощности к той ее части, которая расходуется на работу информационной инфраструктуры и служит наиболее полной интегральной характеристикой эффективности технологических и административных решений, принятых в серверном помещении. Хорошее значение показателя, к которому стремятся передовые разработчики — 1,3. То есть, PUE=1,3 означает, что 30% электроэнергии в год расходуется исключительно на поддержание работоспособности серверного помещения. Лучшие мировые дата-центры имеют приблизительно PUE=1,1. В России для большинства серверных помещений характерен, как правило, показатель PUE=2 или даже хуже. Это значит, что в «воздух» утекает ровно половина всей электроэнергии, расходуемой на работу серверного помещения.

Лучшие крупнейшие дата-центры в России имеют PUE=1,5 и ставят своей задачей снизить этот показатель до значений 1,3.

Достаточно часто энергопотребление серверной комнаты оценивают усреднено в расчете на стандартный телекоммуникационный шкаф типоразмера 19” (на «стойку»). Энергопотребление одной компьютерной стойки может варьироваться в зависимости от установленного оборудования от 2кВт до 40кВт.

Даже если принять, что в небольшом серверном помещении установлено 2 маломощные «стойки» по 5кВт, — чистое энергопотребление стоек будет 10кВт. И при коэффициенте PUE=2 общее энергопотребление серверного помещения составит 20кВт.

Где происходят потери электроэнергии в серверном помещении? Первый источник — потери на пути от поставщика энергии до вычислительной нагрузки. Как правило, они определяются потерями на трансформаторах, на источниках бесперебойного питания (ИБП) и в сети распределения электропитания. Обычно их доля невелика, однако для мощных мегаваттных дата-центров и единицы процентов в абсолютном денежном исчислении хорошо ощутимы. Например, многие относительно дешевые ИБП имеют КПД 85-87%. Это и значит, что 15-13% уже на этом этапе теряется безвозвратно. Современные «продвинутые» ИБП имеют КПД до 96%, что снижает потери энергопотребления до 4%.

Вдумайтесь, 15% потерь на ИБП означает, что это тепло, которое ИБП отводит в воздух. И это избыточное тепло тоже куда-то надо отвести. Чем? Кондиционированием воздуха, в свою очередь. Но кондиционирование воздуха тоже энергоемкая задача.

Однако серверное оборудование требует достаточно жестких климатических условий по эксплуатации для продолжительной бесперебойной работы. Согласно стандарту ASHRAE “Thermal Guidelines for Data Processing Enviroments” 2004 года, рекомендуемая температура 20-25°С при рекомендуемой относительной влажности 40-55%. Кроме того, стандартами нормируется скорость изменения температуры и влажности воздуха в серверном помещении. Скорость изменения температуры в серверном помещении не должна превышать 5° за 1 час. Изменение влажности не должно превышать 20% за 1 час.

Современное серверное оборудование может работать и при более высоких температурах. Слабое место серверов и систем хранения данных — жесткие диски (хранители информации). При повышении температуры воздуха выше 30°С частота отказов жестких дисков лавинообразно нарастает. А вместе с отказом жесткого диска теряется и самое ценное, ради чего строится серверное помещение — информация.

Разница температур воздуха на входе и выходе современного серверного оборудования может составлять 30°С, а в нагруженных режимах до 40°С. Это значит, что при температуре воздуха на входе в сервер 20°С на выходе будет 50°С. И этот уже горячий воздух снова поступает на вход серверного оборудования.

Обеспечить в таких условиях необходимые климатические режимы в серверном помещении 24 часа в сутки, 365 дней в году непросто! Бытовые сплит-системы для этого не подходят. Система кондиционирования воздуха должна обеспечивать требуемые стандартами параметры вне зависимости от температуры окружающего воздуха. А ведь в Кировской области летом на улице может быть и +35°, а зимой и -35°.

В таких условиях на систему кондиционирования воздуха приходится в среднем около 40% всей электроэнергии, потребляемой инженерным оборудованием серверного помещения. Способов снизить расходы на охлаждение воздуха серверной на сегодняшний день придумано много, есть среди них весьма экзотические — охлаждение морской/речной водой, адиабатная технология (испарение), технологии естественного охлаждения, использование отводимого тепла для отопления соседних зданий и т.д.

Еще один способ снизить энергопотребление серверного помещения — эффективная загрузка серверного оборудования. Технология повышения загрузки серверного оборудования называется виртуализация. По статистике, установленное серверное оборудование, особенно старое, чаще всего загружено на 5-30%. При этом каждый сервер потребляет 500-1000Вт. Редкие серверы бывают загружены на 50-60%. А ведь каждый сервер при этом потребляет электроэнергию. Новые современные энергоэффективные серверы позволяют на одной аппаратной платформе запустить множество программных серверов и довести тем самым загрузку сервера до 70-80%. А старые серверы при этом утилизируются.

Таким образом, в среднем по статистике, один новый энергоэффективный сервер, оснащенный технологией виртуализации, потребляющий 500 Вт, способен заменить 5 старых серверов, каждый из которых потребляет 1000Вт. Помимо экономии электроэнергии за счет снижения количества аппаратных серверов есть и другие преимущества — серверы занимают меньше места в стойках, меньшему количеству серверов требуется меньше мощности на охлаждение. Выгоды виртуализации столь очевидны, что это стало причиной победного шествия технологии виртуализации для всех серверных комнат.

Совокупность мер по увеличению энергоэффективности существующих серверных помещений может т привести к суммарному снижению потребления серверного помещения в районе 5-10%. Если рассмотреть серверную с суммарным потреблением 400кВт, то экономия электричества в 20-40кВт/ч при нынешней стоимости электричества в течение года может составить составит 600 000-1 200 000 рублей.

Сегодня проектировать энергоэффективные серверные помещения, используя современные энергосберегающие системы проще и выгоднее, чем это было, скажем, 5 лет назад. Исследования, проведенные экспертами компании Uptime Institute, показывают, что энергопотребление центров обработки данных может быть снижено на 50%, если в процессе проектирования использованы верные решения. По данным аналитического департамента компании АРС, резервы экономии электроэнергии кроются в следующих направлениях: до 40% — при использовании методов виртуализации серверных мощностей, до 15% — при выборе эффективной архитектуры кондиционирования помещения, до 12% — при правильной планировке фальшпола, до 10% — при выборе эффективного оборудования электропитания.

А. Ю. Вепрев, руководитель отдела системных решений АСПЕКТ СПб

Источник: Журнал «ЭКО-ТЕК», №1(42), февраль 2012 г.